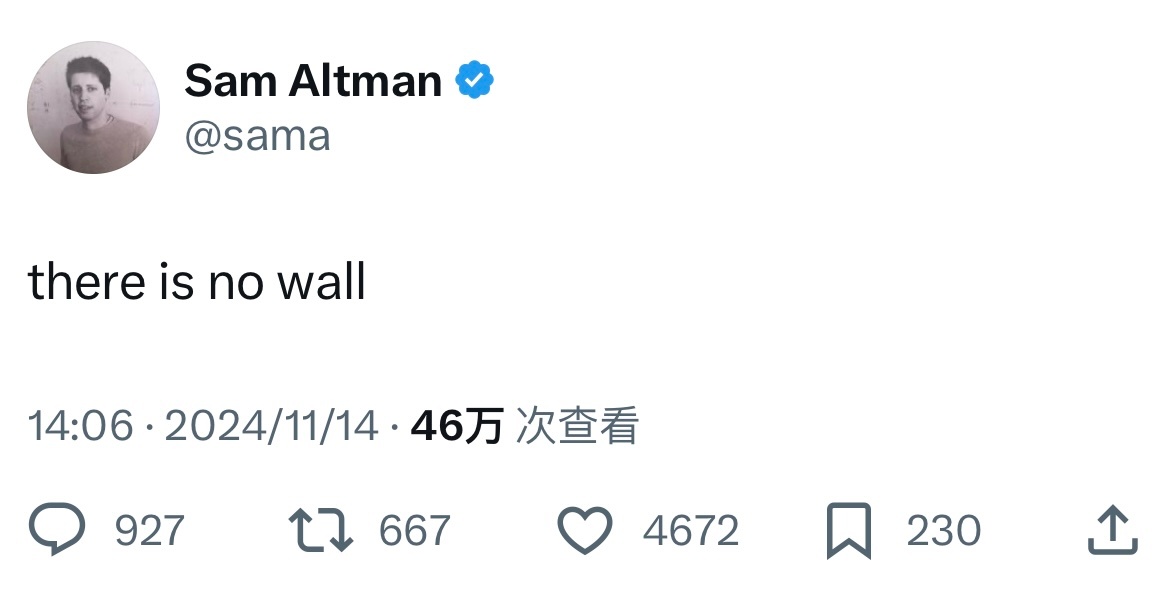

@阑夕:Sam Altman 发了条言简意赅的推文:there is no wall。

终于还是被推出来回应大模型预训练陷入瓶颈的行业恐慌了。

清理了一下时间线,大致上是这样的:

– The Information 率先报道,OpenAI 因为 GPT 系列模型的进化速度放缓,调整了公司战略,GPT-5 难产已成定局;

– Bloomberg 随后助攻,把采写范围扩大到了 OpenAI、Googe 和 Anthropic 三家公司,发现新版模型全在推迟发布,可以看到收益递减曲线;

– AI 社区此时普遍还认为媒体报道有失公允,觉得没有核心从业者出来证言,只是搜集了边角料想搞个大新闻而已,大家不要慌,「且听龙吟」;

– 然后从 OpenAI 出局的前首席科学家 Ilya Sutskever 刚好跳出来补刀,对路透社判断大模型扩展法则确实已经到达了极限,必须改变训练模式;

– Meta 的首席科学家、图灵奖得主 Ynn LeCun 也没放过攻击闭源竞争对手的机会,在 Threads 上表示「我不想说我早就告诉过你,但我确实早就告诉过你」;

– Anthropic 的创始人 Dario Amodei 在播客里安抚市场,认为预训练的扩展法则(Scaling Laws)来自经验而非客观规律,但自己会押它仍然会继续存在;

– 再就是两个小时前,Sam Altman 现身喊话,说物理学不存,不对,是墙不存在。

微信扫一扫打赏

微信扫一扫打赏 支付宝扫一扫打赏

支付宝扫一扫打赏

![马斯克宣称要把自由女神熔了[doge]](https://cdn.bohaishibei.com/thumb/?src=https://img.bohaishibei.com/2024/12/12/T2rnfjYPzXGmAw4.jpg&w=400&h=260)